De Facebook incluso hablan algunas empresas y todos, "visitantes" y "residentes digitales". De Twitter hablamos (mucho) los "residentes", unas pocas empresas, gabinetes de prensa y pronto también, a juzgar por su crecimiento en los últimos tiempos (según datos de Nielsen, los visitantes únicos de Twitter.com se incrementan en un 1,382 por ciento cada año, desde los 475,000 en Febrero de 2008 a los 7 milones en Febrero de 2009, situándose como el sitio comunitario con mayor crecimiento registrado), el resto de la población con acceso a internet.

El 2.5% de la población mundial está en FB. Y eso, como comenta Alejandro Piscitelli, cuyo proyecto Facebook inspira en parte este trabajo, trasladado a un 5% o 10% de la población (mas del 15% en USA), ya no trata sobre una muestra o un subconjunto de la población sino del universo total.

No en vano diría recientemente Danah Boyd que las redes sociales están aquí para quedarse. La web 2.0 no solo es para adolescentes, ni un fenómeno pasajero, como parecen entenderlo quienes no se la están tomando en serio o siguen temiéndola por cuestiones de privacidad o seguridad .

- UNA SOLA CULTURA (la de la persuasión) PARA LAS REDES SOCIALES

Facebook, Twitter son dos redes aparentemente distintas que, en mi opinión y a pesar de haber nacido con muy distintos preceptos, parecen tender a la convergencia hoy, entre otros, por un motivo fundamental: la apropiación por parte de las personas de las Nuevas Tecnologías, que termina por adaptarlas, si quieren triunfar, a nuestras propias necesidades y usos.

Lo dicen, en otros términos y desde distintas perspectivas tanto David Armano ("las ideas relativas a comportamientos llevan a la innovación") como B.J.Fogg, uno de los líderes mundiales en captología (el poder persuasivo de la computación): Facebook si bien no hace nada nuevo, integra 6 funciones en distintas modalidades de comunicación e interconexión entre la gente. Experiencia persuasiva, estructura automatizada, distribución social, ciclos rápidos, enormes grafos sociales e impacto mensurable. Su principal hipótesis de trabajo, que creo que podríamos trasladar a Twitter, es que Facebook haría posible nuevas formas persuasivas, de motivación. Así, todo estudio de Facebook deberia verse pues, también como un capitulo en la psicología de la persuasión.

Andaba leyendo, reflexionando sobre todo ello, cuando este twitteo de @ignacionacho confirmaba mi hipótesis:

"ayer descubrí que @Yoriento y @seniormanager son personas físicas, no meros entes dos punto cero".

También en Twitter, YA, somos reales. Y es que a pesar de haber nacido para distintos públicos, con distintas funciones y con distintas estrategias de implantación, negocio, etc…, FB y Twitter cada día suponen en menor medida las distintas culturas de las que hablamos en su momento y tienden a converger en tipos de usos, usuarios y funciones.

Incluso va dejando de ser cierto aquello que concluíamos en una reciente conversación: FB, que construíamos en principio según hubiésemos conocido en tiempos remotos a nuestros contactos, mira al pasado. Twitter, que construimos según pensemos que nuestros "following" van a aportarnos interesantes ideas y enlaces, al futuro.

Todo ello cobra sentido según la siguiente hipótesis, a la que también apuntábamos hace tiempo:

- La experiencia de FACEBOOK COMO proceso de EVANGELIZACIÓN DIGITAL:

Hablábamos hace un tiempo, refiriéndonos a FB y Twitter (Facebook, twitter, dos formas de entender la red) de 2 modelos de negocio, 2 formas de entender, 2 formas de vivir la red. La idea principal era que Facebook, nacida para un target poco habituado a lo digital, se establecía como red social en base a distintas metáforas de lo real. Twitter, en cambio, no necesitaba de "florituras" y era tomada por usuarios "geek", navegantes habituales de la red (residentes digitales) como red de interés en la cual añadir contactos, no según si los conocíamos o no en la vida real, sinó según nuestra coincidencia con los temas que trataban.

Dicho en otros términos, Facebook, la "red de las caras", era una red mucho más fiel a lo que tradicionalmente podemos entender como red "social". Estaba, "a un solo paso de la realidad". Sería un entorno cuyo éxito residía en haber sabido adaptarse y evolucionar a la medida de la alfabetización digital de sus usuarios.

Leo hoy una idea similar: en palabras de AIdan Henry ("How Facebook Is Bringing Web 2.0 Mainstream"): FB es el gran evangelizador de la web 2.0. Su éxito, su ventaja comptetitiva ha estado en adoptar una política de alfabetización digital masiva, rebautizando -permitiendo su apropiación masiva- muchas de las herramientas Web 2.0.

En palabras de Alejandro:

"Facebook está contribuyendo a la alfabetización digital por caminos inéditos (caracterizado por el casi nulo costo cognitivo, la casi no intersección entre una proporción enorme de usuarios y otros usos de la web, a excepción del correo electrónico, o la potencial aparición de redes sociales de segunda generación temáticas y de nicho -usando plataformas como Ning- para las cuales Facebook seria la propedéutica y el entrenamiento, necesario pero pasajero? - Facebook es una poderosa herramienta de alfabetización digital inocua y transparente".

Hoy, cuando los usuarios de FB ya han superado en parte el déficit digital con el que llegaron, parece que empieza a parecerse a Twitter. Cada vez son menos necesarias sus metáforas de realidad, permite acualizar nuestro estado como lo hace twitter y refuerza su faceta sobre "páginas", permitiendo que sean también los intereses comunes, más allá de espejos de identidades físicas, los que puedan motivarnos a entrar en su jardín vallado.

En cuanto a Twitter y como si hubiera sufrido un proceso inverso, empezamos a vivir la sobre abundancia de aplicaciones, la importancia del perfil, además de la del status y sobretodo su reciente y creciente utilidad de herramienta de búsqueda en tiempo real, como una ventana sincrónica a la realidad.

Transmiten, reflejan, en definitiva, una misma cultura, la que denominaremos….

- CULTURA DE LA CELEBRIDAD, DE LA CONECTIVIDAD

Lo apuntábamos en el punto anterior: En Facebook importaba sobre cualquier otra cosa si conocíamos o no a nuestros contactos. Como ocurre con los blogs, la pestaña "Sobre mi" era sobredimensionada en su importancia. La página de perfil personal, su sofisticación a base de apliaciones, era mucho más importante que los contenidos que se aportaban a la plataforma.

El tema nos lleva a pensar en una cultura de la celebridad. Como diría Alejandro, la "mancha digital", aparecer etiquetados junto a alguien célebre, será la nueva forma del contagio de famosos…

La idea la desarrollan Michael A. Stefanone, Derek Lackaff & Devan Rosen en We're All Stars Now: Reality Television, Web 2.0, and Mediated Identities :

Con apoyos en la teoría cognitiva social los autores muestran una correlación significativa entre el crecimiento de la audiencia de reality shows, y el aumento exponencial de habitantes en las redes sociales.

Algo similar nos decía El fin de la soledad:

¿Qué quiere el yo contemporáneo? La cámara ha creado una cultura de la celebridad, los ordenadores, de conectividad. Cuando la web ha permitido la convergencia entre ambas y las redes sociales han extendido la interconectividad, las dos culturas se han unido: La celebridad y la conectividad son formas de ser conocidos. Y eso es lo que quiere el ser contemporáneo: ser visible. Ante millones o como mínimo, cientos, como en Twitter o Facebook. Esa es la calidad que nos valida, la forma en que nos convertimos en reales para nosotros mismos — siendo vistos por los demás. El gran terror contemporáneo es el anonimato. Si Lionel Trilling acertaba, la propiedad que basaba el self en el romanticismo era la sinceridad y en el modernismo la autenticidad, durante el posmodernismo es la visibilidad.(…)

Así, a diferencia de lo que ocurría en los orígenes de la red, cuando uno de sus principales atractivos era la opción de jugar, de falsear nuestras identidades, parece que la web social nos lleva a no querer ser anónimos y preocuparnos, sobretodo, de construir con fidelidad nuestra identidad digital, unificándola incluso con la física.

El tema lleva, según David Armano, incluso, a debilitar las funciones de lo institucional en favor del valor de las personas:

Llegamos a identificarnos con tanta fuerza con nuestros intereses, se ha visto aumentado de tal forma nuestro poder de persuasión, que todo el mundo puede convertirse en tema (página) en Facebook o gestionar tópicos de interés aglutinadores de personas (como antes lo hacían solo las instituciones) en Twitter.

Pero todo proceso de democratización, de horizontalización de las relaciones de poder entre seres humanos conlleva resistencias….

- OTRA VEZ CON LA CALIDAD..:

Ya sucedió con los blogs (Google nos hace estúpidos… (menos a mi)) y el presupuesto, fundado en prejuicios más que en hechos reales, de que la calidad de sus contenidos era menor que la que producían prensa, medios masivos digitales, etc…

Estoy invitada a las jornadas de la Catosfera para hablar sobre el Futuro de los blogs y pensando acerca del tema me he dado cuenta de que, afortunadamente, gracias a la selección natural y a pesar de los esfuerzos tecnocatastróficos y elitistas de Nicolas Carr, entre otros, el debate sobre la calidad de los contenidos en los blogs, en muy poco tiempo, ha dejado de tener sentido.

Las opiniones retrógradas, resistentes al cambio, se traslada ahora a las redes sociales, en las que se reabre la polémica y algunos se plantean si lo que aumenta con el número de contactos que somos capaces de manejar es la debilidad, la escasa calidad o incluso la realidad de los mismos.

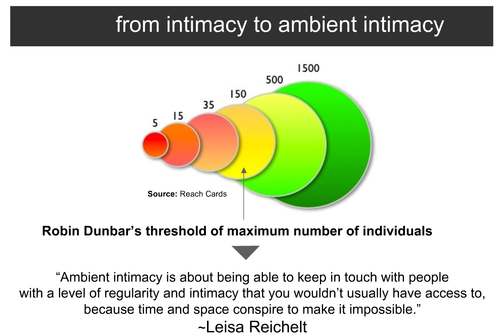

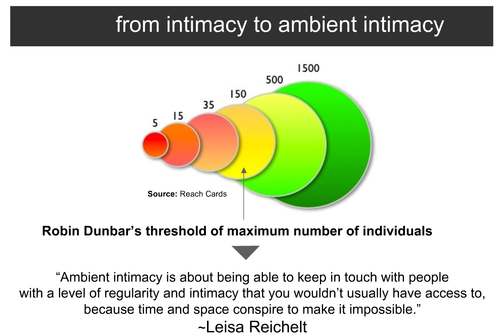

Importante para hablar del tema es la valoración del estudio de Bernardo A. Huberman, Daniel M. Romero y Fang Wu, en el que analizan a través de Twitter la relación de contactos en una red y la calidad o incluso presencia de comunicación entre ellos para llegar a la siguiente conclusión: un link entre dos personas no supone interacción (efectiva) entre ellas.

Ampliando un poco la idea, el estudio concluye que para medir la actividad de una persona en una red social, su número de amigos (personas con las que intercambia mensajes directos) es mejor indicador que su número de contactos o de seguidores. Estos son, según esl estudio, aproximadamente un 13% de los "followers".

Me pregunto porqué no se tiene en cuenta el carácter no siempre bidireccional de la comunicación, en mayor medida según estudios sobre participación, en Internet (recordemos la famosa e inexorable regla de la participación online, 90% de observadores, de Lurkers frente al 10% que participan de forma activa). ¿No constituye una relación significativa el hecho de ser observador pasivo, lector más o menos fiel de los contenidos de otro?

Se habla de redes nominales vs redes reales, surgen cuestionamientos sobre la intimidad o incluso dudas de que las redes sociales online pueden considerarse como un modelo adecuado de propagación de ideas o de formación de lazos sociales.

En el mismo sentido van las ideas de Dunbar, que teorizó que el límite de relaciones significativas o el tamaño máximo de un grupo para mantenerse unido es de 150 personas. Más allá de este límite, debía existir un incentivo muy alto para mantener el grado de intimidad y significación en las relaciones (para mantener la "Intimidad"). Para que un grupo de este tamaño posea esa cohesión, Dunbar especuló que por lo menos un 42% del tiempo del grupo se debía dedicar a la socialización.

Seguiremos hablando de ello, de cómo las redes sociales construyen, modifican o moldean nuevos tipos de relación. Quizás, como reformula el tema David Armano, casi en positivo, también en su interesante presentación sobre Micro-sociología de las redes sociales, no es que la amistad haya muerto pero el aumento cuantitativo de nuestros límites, abriéndonos a más conexiones y relaciones de las que realmente podemos manejar, puede estar transformando el concepto.